引言

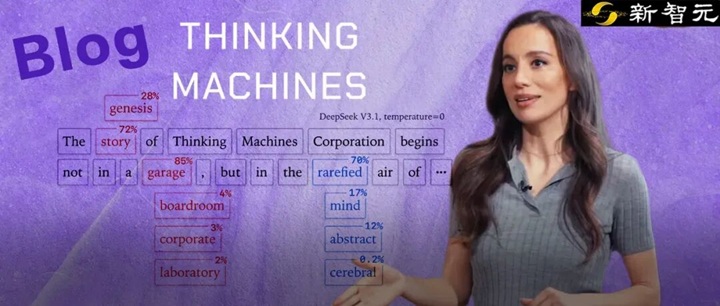

本视频全面且深入地剖析了大型语言模型开发过程中一个普遍存在却又经常被忽视的技术难题:为什么在确保输入内容完全相同并且随机种子被精确固定的情况下,大型语言模型依然会产生不一致、不可预测的输出结果?这种现象不仅困扰着研发人员,也严重影响了模型在需要高度一致性的场景中的应用。基于由OpenAI前首席技术官米拉·穆拉蒂创立的Thinking Machines Lab团队最新发布的突破性研究成果,本视频系统地揭示了这一令人困惑的现象背后的核心技术原理,深入解析了问题的根源,并详细介绍了他们提出的创新性解决方案与实现方法。

视频

主要内容部分

Thinking Machines Lab背景

- 创立背景:由OpenAI前CTO米拉·穆拉蒂创立

- 融资情况:2024年7月完成20亿美元种子轮融资,估值120亿美元

- 投资方:A16z领投,英伟达、AMD、思科等科技巨头跟投

- 研究博客:名为”Connectionism”(联结主义),专注AI科学理解

问题现象分析

- 常见误解:许多人将非确定性归因于GPU并发执行或浮点数运算误差

- 真实现象:即使使用vLLM、SGLang等开源推理库,在固定硬件上仍会出现结果不一致

- 实验发现:相同输入在1000次采样中产生了80个不同结果

核心原因:批次不变性缺失

- 批次处理机制:服务器会根据负载情况将多个用户请求打包成批次处理

- 问题本质:相同输入在不同批次大小下会产生不同输出

- 根本原因:浮点数的非结合性特性导致归约顺序变化影响计算结果

浮点数非结合性详解

- 定义:(a+b)+c ≠ a+(b+c)

- 实例:(0.1 + 1e20) – 1e20 = 0,但0.1 + (1e20 – 1e20) = 0.1

- 影响:在矩阵乘法、RMSNorm、注意力机制等核心操作中被无限放大

解决方案:批次不变内核

RMSNorm优化

- 问题:批次变化导致归约策略改变(数据并行 vs 分割归约)

- 解决方案:强制采用数据并行策略,确保每个批次元素在单个核心内完成归约

矩阵乘法优化

- 问题:Split-K策略和张量核心指令选择影响归约顺序

- 解决方案:禁用Split-K策略,固定张量核心指令尺寸(如128×128×32)

注意力机制优化

- 问题:FlashAttention2在不同阶段采用不同并行策略

- 解决方案:固定KV缓存分割大小,统一数据布局格式

实验效果验证

- 测试模型:Qwen3-235B-A22B-Instruct-2507

- 测试条件:温度设置为0(贪婪采样),1000次采样

- 优化前结果:80个不同输出,从第103个token开始分歧

- 优化后结果:1000次采样完全一致,零差异

性能与应用价值

- 性能损耗:未优化版本降速2倍,优化后损耗控制在20%左右

- 应用场景:金融AI、医疗诊断、强化学习训练等需要结果一致性的领域

- 强化学习突破:实现真正的在线策略强化学习(On-Policy RL)

行业影响与前景

市场地位

全球AI市场预计到2028年将超过5000亿美元,由机器学习、自然语言处理和各行业AI驱动应用的进步推动。Thinking Machines Lab对人类对齐AI的关注使其能够利用这一增长,满足对道德和透明AI解决方案日益增长的需求。

技术贡献

该博客文章提供了对硅谷最受关注的AI初创公司之一的罕见窥视。虽然它没有概述其技术的完整方向,但明确表示Thinking Machines Lab正在应对AI研究前沿最艰难的一些挑战。

未来展望

实验室的研究博客Connectionism与非确定性研究一起推出,表明了对透明度的承诺。通过分享对前沿AI系统的见解,Thinking Machines Lab希望促进更广泛的讨论,并使用户能够有效利用AI。

Thinking Machines Lab代表了AI研究领域的一个重要转折点,它不仅汇集了业界顶尖人才,更重要的是承诺回归开放科学的传统,专注于解决AI系统的基础性问题。通过其Connectionism研究博客,公司正在为AI领域的科学理解和技术进步做出重要贡献,这种承诺可能会重新定义AI行业的发展方向。

结论与关键要点

主要发现

- 核心问题识别:大模型推理非确定性的根本原因是批次不变性缺失,而非GPU并发或浮点数误差

- 技术突破:通过批次不变内核实现了真正的可重复性

- 科学意义:为大模型的可重复性和可靠性提供了科学解决方案

关键技术要点

- 浮点数非结合性是导致计算结果差异的根本原因

- 归约顺序的一致性是确保批次不变的关键

- 性能损耗与结果一致性之间的平衡是可以接受的

未来影响

- 产品可靠性:AI产品将变得更加可靠和一致

- 技术竞争:底层计算确定性可能成为大模型技术竞争的新焦点

- 科学研究:强化了AI研究中可重复性的重要性